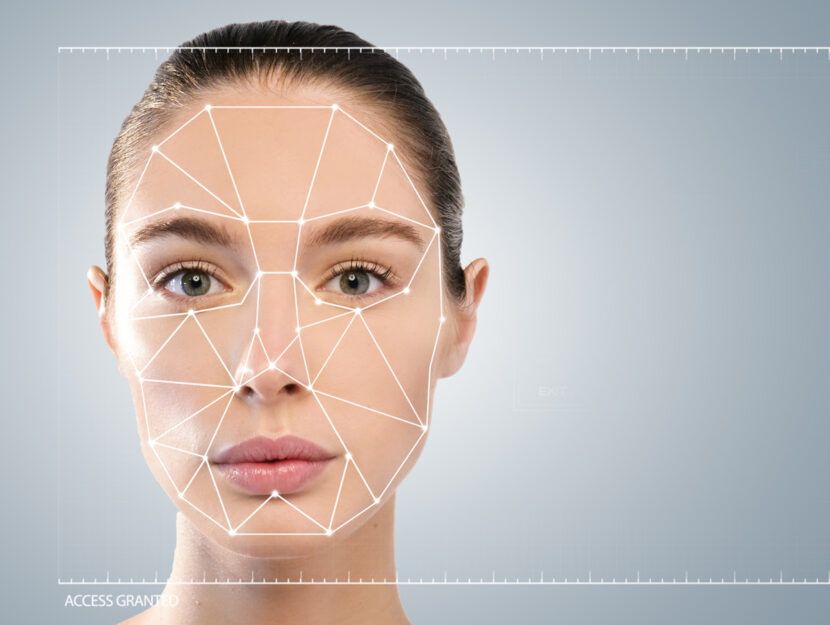

Di certo lo abbiamo già (forse inconsapevolmente) sperimentato, per superare i controlli in aeroporto o per sbloccare lo smartphone. È il riconoscimento facciale, la tecnica di intelligenza artificiale che permette di verificare l’identità di una persona a partire da una sua immagine. Consente di velocizzare molte operazioni che richiedono di stabilire che tu sia proprio tu: dall’home banking alla sorveglianza pubblica nelle piazze. Come le altre innovazioni tecnologiche, però, per facilitarci la vita pretende in cambio qualcosa: la nostra faccia, più precisamente, i dati biometrici che rendono unico un viso.

Servono norme più chiare su cosa è lecito e cosa no

Si tratta di un’intrusione enorme nella sfera privata di un individuo. E un furto o una violazione di questa informazione – gli esperti lo chiamano “data breach” – può comportare conseguenze gravi. Il tema è caldo in tutto il mondo e la stessa Commissione Ue se ne sta occupando. «In Europa mancano le linee guida di applicazione del Gdpr, la legge sulla privacy» spiega Marisa Maraffino, avvocatessa esperta in reati informatici e privacy aziendale. «Secondo le norme, è lecito raccogliere i dati personali senza consenso per motivi di sicurezza. I motivi, però, non sono ancora stati dettagliati. In più, molti Stati non sono pronti alla gestione massiva delle informazioni». E, secondo un recente studio pubblicato da Comparitech, proprio l’Italia è all’ultimo posto in Europa per la protezione della privacy garantita ai cittadini.

La polizia italiana adopera programmi di sorveglianza

Ma cosa è più rischioso per la nostra privacy: il sistema di sblocco del telefono o le telecamere piazzate in luoghi strategici come gli stadi? Quando accettiamo di usare il riconoscimento facciale sul cellulare, dobbiamo dare un consenso, poi i nostri dati biometrici “restano lì”, non vengono condivisi. Nel momento in cui il riconoscimento facciale viene incorporato nelle telecamere di sorveglianza, invece, non ci viene chiesto alcun consenso e la nostra immagine potrebbe essere condivisa su alcuni database. Servono quindi risposte chiare a domande cruciali: chi è autorizzato a vedere e usare questi dati? Per quanto tempo e come sono conservati? «L’utilizzo del riconoscimento facciale pubblico è già un fatto concreto in tutto il mondo» spiega Marisa Maraffino. «Per esempio, in Germania è pronto un programma di sorveglianza in 134 stazioni e 14 aeroporti. In Italia la polizia utilizza dal 2017 S.A.R.I., il Sistema automatico di riconoscimento immagini, un software che permette di trovare il volto di un ricercato all’interno di un database di circa 10 milioni di immagini. È uno strumento utilissimo nelle indagini, ma presuppone fiducia nelle istituzioni e nella democrazia».

L’innovazione deve essere una scelta condivisa

Oggi sembra che per la prima volta la società civile si mostri consapevole del fatto che l’innovazione non è un destino ineluttabile ma una scelta condivisa. Un esempio? Un mese fa i tifosi di 2 squadre di calcio inglesi si sono ribellati, indossando una maschera, contro la decisione della polizia di impiegare la tecnologia durante la partita, per individuare le persone a cui era stato vietato l’ingresso negli stadi. Un portavoce della protesta ha dichiarato eccessiva una misura che avrebbe portato alla schedatura di cittadini incensurati e persino di bambini. «Il timore di essere guardati a livello pubblico è particolarmente sentito nella cultura europea, perché l’Europa ha una visione “umanocentrica” dell’uso della tecnologia. Non è però così nel resto del mondo» spiega Emanuela Girardi, membro del gruppo di esperti di Intelligenza artificiale del Mise, ministero dello Sviluppo economico e founder dell’associazione Pop Ai. «In Cina e in Australia il riconoscimento facciale è accolto. Posso raccontare anche, per esempio, di una collega brasiliana che trovava molto opportuno l’uso delle telecamere di sorveglianza durante il carnevale di Rio».

Questi sistemi non sono ancora impostati in modo efficace

«I benefici nel campo della sicurezza, ma anche della diagnostica medica e nei sistemi di pagamento saranno straordinari, però la tecnologia va ancora implementata. Finora gli algoritmi dell’intelligenza artificiale si sono rivelati meno “intelligenti” di quanto siamo portati a credere» spiega Emanuela Girardi. «L’inaffidabilità dipende anche dall’errore umano. Gli algoritmi imparano a riconoscere i dati biometrici a partire da un addestramento fatto su milioni di immagini, che possono essere scelte male e catalogate peggio attraverso un lavoro inaccurato». E le conseguenze possono essere disastrose: basti ricordare che un software progettato da Amazon per le forze dell’ordine americane in fase di test ha confuso 28 parlamentari con altrettanti criminali archiviati nei database della polizia.