La prima volta che che mi sono resa conto di essere davvero controllata è stata all’aeroporto di Londra qualche anno fa. Uscendo dal gate dove era atterrato il mio aereo, mi sono trovata, insieme a decine di persone, sotto alle telecamere che, grazie a un sistema di luci, attiravano il mio sguardo in modo da rendere “scoperto” il mio volto. Ho avuto la netta sensazione che dall’altra parte ci fosse un Grande Fratello in grado di identificarmi e decidere se mettermi nella lista degli individui indesiderati o no. Immaginate quindi cosa significhi essere sotto una lente h24, riconosciuti da un software che, guardando la vostra faccia, sappia dire chi siete, cosa fate, dove abitate.

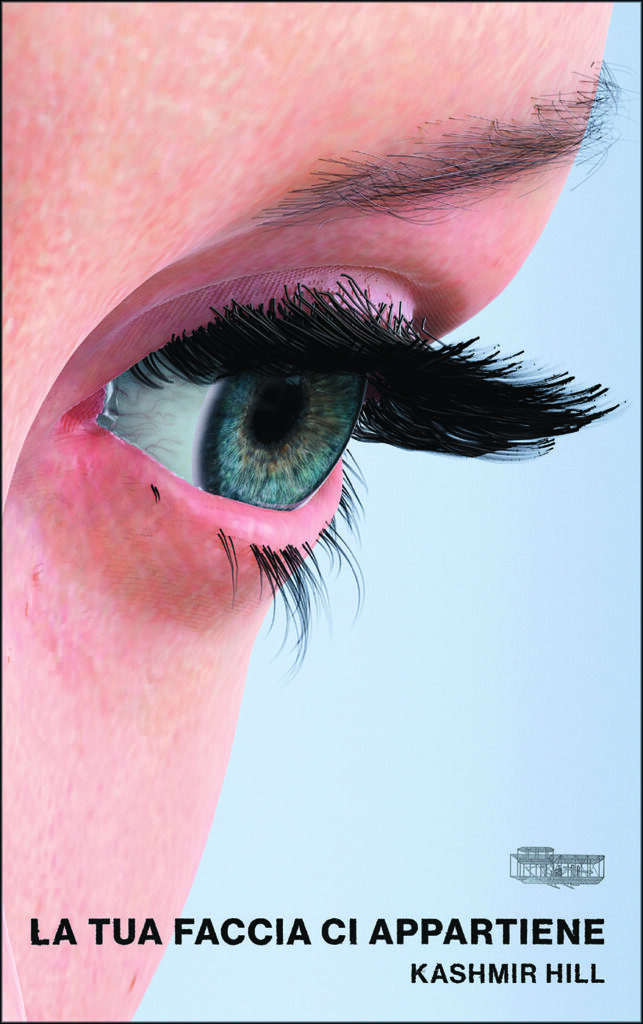

E se una tua foto dicesse tutto di te?

Kashmir Hill, giornalista del New York Times, ha realizzato un’indagine accurata sulle nuove tecnologie di riconoscimento facciale, mettendosi sulle tracce della start-up Clearview AI e del suo fondatore Hoan Ton-That, in La tua faccia ci appartiene (Orville Press). Un libro che ha il passo del thriller – tutto inizia da una soffiata per svilupparsi in un inseguimento pieno di depistaggi degno di un film – e ci mette in guardia su quello che è già diventato uno scenario alla Minority Report.

Grazie a questa app di riconoscimento facciale – «usata 1 milione di volte dalle forze dell’ordine negli Usa» ha detto Ton-That in un’intervista, ma multata per 20 milioni di euro dal Garante per la privacy in Italia – oggi si può sapere tutto di una persona a partire da una sua foto: nome, cognome, lavoro, amicizie… Impossibile nascondersi o fare appello alla privacy. «Sarebbe un po’ come se tutti diventassimo dalla sera alla mattina celebrities, facce che chiunque riconosce» scrive Kashmir Hill.

Intervista a Kashmir Hill

Come siamo arrivati a questo punto?

«Credo che la maggior parte di noi sia stata a lungo inconsapevole della potenza del riconoscimento facciale, ma in un certo senso siamo noi stessi quelli da biasimare. Postiamo online centinaia di nostre foto in eventi pubblici e privati: immagini dove i volti sono riconoscibili e taggati, e che sono state poi utilizzate per sviluppare questa tecnologia. È stato un processo lungo che però negli ultimi 2-3 anni ha subito un’accelerazione».

Con i social media la privacy sembra quasi aver perso di significato. Perché, allora, ci fa così paura questa tecnologia?

«La raccolta dei dati a partire dalla nostra attività online è diffusa ma difficile da percepire. Qui si tratta del volto, considerato più “personale”. Il riconoscimento facciale può essere positivo se aiuta le forze dell’ordine a rintracciare l’autore di un crimine, non lo è se usato in qualsiasi momento, quando siamo convinti di essere nell’anonimato. Pensi che in Russia chi ha protestato contro la guerra in Ucraina è stato riconosciuto in mezzo alla folla».

Lo step successivo del riconoscimento facciale potrebbe essere la capacità di capire cosa stiamo pensando?

«Ci sono già delle compagnie che ci stanno lavorando. Zoom, per esempio, sta sperimentando l’Intelligenza artificiale legata alle emozioni per usi commerciali: in una riunione si può scoprire se la persona a cui ci si sta rivolgendo è interessata, se la sua attenzione è scemata e in che momento. Ci sono progetti per capire quali emozioni si provano davanti a un film o a una pubblicità. Si è parlato di software per la sicurezza negli aeroporti per segnalare se c’è qualcuno particolarmente nervoso. E ci sono anche progetti di questo tipo che possono aiutare le persone nello spettro autistico. Ma qual è l’effettivo funzionamento di queste tecnologie? Se lo chiedono gli studiosi, perché da una parte le emozioni sono un fatto culturale e dall’altra le espressioni del volto non sempre rispecchiano davvero le emozioni provate».

C’è un modo per fermare queste tecnologie?

«È difficile, perché alla base ci sono aziende che cercano profitti. I sistemi di riconoscimento facciale hanno valore sul mercato: interessano agli aeroporti, alle forze dell’ordine, ai commercianti che vogliono sapere se chi entra nel loro negozio è stato in passato arrestato per furto. Inoltre c’è quella che io descrivo nel libro come “technical sweetness”, la dolcezza tecnologica: il desiderio degli esseri umani di capire fin dove possiamo arrivare. Chi è ottimista rispetto a queste tecnologie non ne vede le conseguenze negative che riguardano la privacy».

Perché Facebook e Google, che pure dispongono di queste tecnologie, non le usano?

«L’ex ceo di Google, Eric Schmidt, sebbene riconoscesse i vantaggi, disse che i rischi erano troppi: per esempio, che finissero in mano a un dittatore che, così, avrebbe potuto controllare la popolazione. Mentre Facebook era già stata sotto processo per temi legati all’utilizzo dei dati senza consenso e ha temuto ulteriori scandali, anche se il loro attuale chief technology officer parla di introdurre il riconoscimento facciale negli occhiali per la realtà aumentata. Le grandi aziende sono sotto osservazione ed è per questo che una compagnia molto più piccola come Clearview AI si è fatta strada. La stessa cosa è successa con l’Intelligenza artificiale generativa, basti pensare a OpenAI».

Le leggi, come quella europea sull’Intelligenza artificiale, sono utili per regolamentare queste tecnologie?

«Sì. Negli Usa, per esempio, abbiamo preso molto dal Gdpr europeo sulla protezione dei dati, come il diritto a essere dimenticati. Credo che l’Europa svolga un ruolo importante nel creare una serie di regole che poi vengono seguite dalle compagnie tecnologiche in tutto il mondo. Clearview AI oggi può essere usata solo dalle forze dell’ordine, ma ci sono altre compagnie con database più piccoli di immagini prese solo dai siti di news che possono essere utilizzate da tutti».